Dieses Jahr werden John Hopfield und Geoffrey Hinton mit dem Physik-Nobelpreis ausgezeichnet – eine Anerkennung ihrer bahnbrechenden Arbeit im Bereich der Hopfield-Netze: https://www.nobelprize.org/prizes/physics/2024/popular-information/?utm_source=twitter&utm_medium=social+media+&utm_campaign=nobel+prize+announcements+2024&utm_content=post

Diese besondere Form künstlicher neuronaler Netze, die bereits in den 1980er Jahren entwickelt wurde, hat tiefe Wurzeln in der Physik und Mathematik und unterscheidet sich von klassischen neuronalen Netzen in mehrfacher Hinsicht. In diesem Artikel werfen wir einen Blick auf die Unterschiede zwischen diesen Netztypen und beleuchten die Bedeutung der Hopfield-Netze in der heutigen KI-Forschung.

1. Klassische neuronale Netze: Eine kurze Übersicht

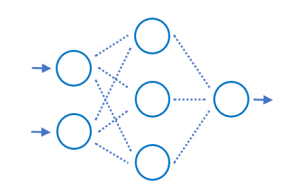

Klassische neuronale Netze (Feedforward-Netze), wie sie in vielen modernen Anwendungen der Künstlichen Intelligenz (KI) verwendet werden, bestehen aus mehreren Schichten von Neuronen, die Daten in einer gerichteten Weise verarbeiten. Die grundlegende Struktur eines solchen Netzwerks sieht wie folgt aus:

- Eingabeschicht: Neuronen empfangen die Rohdaten (z. B. Bilder, Texte).

- Verborgene Schichten: Diese Schichten verarbeiten die Daten durch gewichtete Verbindungen und Aktivierungsfunktionen.

- Ausgabeschicht: Diese liefert das finale Ergebnis, z. B. eine Klassifikation oder Vorhersage.

Der Informationsfluss in klassischen neuronalen Netzen ist unidirektional, das heißt, die Daten fließen von der Eingabe zur Ausgabe ohne Rückkopplung. Diese Art von Netzwerken ist besonders gut für Probleme wie Klassifikation, Regression und Mustererkennung geeignet. Ein typisches Beispiel ist das Convolutional Neural Network (CNN), das in der Bildverarbeitung eine zentrale Rolle spielt.

2. Hopfield-Netze: Was sie besonders macht

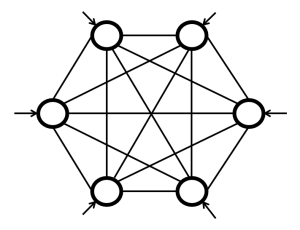

Hopfield-Netze, entwickelt von John Hopfield, stellen eine völlig andere Art neuronaler Netze dar. Diese Netzwerke sind vollständig miteinander verbunden und zeichnen sich durch rekurrente Verbindungen aus. Dies bedeutet, dass jedes Neuron sowohl die Eingänge von anderen Neuronen als auch seine eigenen Ausgaben empfangen kann.

Einige zentrale Eigenschaften von Hopfield-Netzen sind:

- Assoziatives Gedächtnis: Hopfield-Netze werden oft als Modelle für das Gedächtnis verwendet. Sie können Muster speichern und sind in der Lage, unvollständige oder verrauschte Eingaben zu vervollständigen, indem sie die gespeicherten Muster „rekonstruieren“.

- Binäre Neuronen: In der ursprünglichen Form von Hopfield-Netzen sind die Neuronen binär, das heißt, sie können nur die Werte -1 oder 1 annehmen (oder 0 und 1 in einigen Versionen). Dies führt zu einer diskreten Dynamik.

- Energie-Minimierung: Hopfield-Netze arbeiten nach einem physikalischen Prinzip, das an die Thermodynamik erinnert. Jedes Netzwerk verfügt über eine Energie-Funktion, die während der Laufzeit minimiert wird. Ein stabiler Zustand des Netzwerks entspricht einem lokalen Minimum dieser Energie, was oft einem gespeicherten Muster entspricht.

3. Funktionsweise eines Hopfield-Netzes

Der Lernprozess in einem Hopfield-Netz ist vergleichsweise einfach. Es verwendet den Hebb’schen Lernalgorithmus, der auf der Idee basiert, dass die Gewichtungen zwischen Neuronen verstärkt werden, wenn beide gleichzeitig aktiv sind („Neuronen, die zusammen feuern, vernetzen sich“). Hopfield-Netze speichern auf diese Weise mehrere Muster, indem sie die Gewichte entsprechend der Korrelation der Neuronenaktivitäten einstellen.

Ein Beispiel für die Funktionsweise eines Hopfield-Netzes ist die Bildrekonstruktion. Ein verrauschtes Bild, das dem Netzwerk als Eingabe gegeben wird, kann zu einem gespeicherten Muster „korrigiert“ werden, da das Netzwerk in einen stabilen Zustand übergeht, der diesem Muster entspricht.

4. Unterschiede im Überblick

| Merkmal | Klassisches neuronales Netz | Hopfield-Netz |

|---|---|---|

| Architektur | Mehrschichtig, unidirektional | Vollständig verbunden, rekurrent |

| Informationsfluss | Vorwärts (Feedforward) | Rückkopplung (rekurrent) |

| Verarbeitung | Klassifikation, Regression | Mustererkennung, Gedächtnismodellierung |

| Dynamik | Fest, nach Durchlauf beendet | Energie-Minimierung, Zustandssuche |

| Neuronale Aktivierung | Kontinuierlich (z. B. Sigmoid) | Binär (1/-1) |

| Anwendung | Bild-/Spracherkennung, Vorhersagen | Assoziatives Gedächtnis, Mustervervollständigung |

5. Bedeutung der Hopfield-Netze in der heutigen Forschung

Obwohl Hopfield-Netze in den letzten Jahrzehnten weniger populär waren als tiefe neuronale Netze, haben sie nach wie vor große Bedeutung in der theoretischen Forschung. In den letzten Jahren wurden Ideen aus Hopfield-Netzen wiederaufgenommen und erweitert, insbesondere im Zusammenhang mit Energy-Based Models (EBMs) und rekurrenten neuronalen Netzen (RNNs).

Geoffrey Hinton, der ebenfalls für seine Arbeit im Bereich Deep Learning bekannt ist, hat stark zur Wiederbelebung energie-basierter Netzwerke beigetragen. Solche Modelle minimieren Energie ähnlich wie Hopfield-Netze, was sie für moderne KI-Anwendungen, insbesondere in Bereichen wie unsupervised Learning, relevant macht.

6. Zwei Welten der KI

Während klassische neuronale Netze weiterhin die Praxis dominieren, bieten Hopfield-Netze wertvolle Einsichten in die Funktionsweise von Gedächtnis und Mustererkennung. Die Auszeichnung von John Hopfield und Geoffrey Hinton mit dem Physik-Nobelpreis 2024 würdigt nicht nur historische Entwicklungen, sondern verdeutlicht auch, wie tief die Verbindungen zwischen Physik und künstlicher Intelligenz sind. Beide Netztypen tragen auf ihre Weise zur Lösung komplexer Probleme bei und formen gemeinsam das Fundament der modernen KI-Forschung.

Die Auszeichnung erinnert uns daran, wie wichtig es ist, alte Ideen neu zu entdecken und weiterzuentwickeln – denn in der KI gibt es oft nicht den einen „richtigen“ Weg, sondern viele mögliche Ansätze, die in Kombination das volle Potenzial entfalten.