Feature Pyramid NetwoFeature Pyramid Networks (FPNs) haben sich als leistungsstarke Erweiterung für Convolutional Neural Networks (CNNs) etabliert, insbesondere im Bereich der Objekterkennung. Sie ermöglichen es, Objekte unterschiedlicher Größen effektiver zu erkennen, indem sie Merkmale auf mehreren Skalenebenen nutzen.

Motivation für Feature Pyramid Networks

In der Objekterkennung ist die Skalierung eine zentrale Herausforderung. Objekte können in Bildern in verschiedenen Größen auftreten, und ein effektives Modell muss in der Lage sein, sowohl kleine als auch große Objekte zuverlässig zu identifizieren. Traditionelle CNNs extrahieren Merkmale auf einer einzigen Auflösungsebene, was die Erkennung von Objekten unterschiedlicher Größen erschwert. Hier setzen FPNs an, indem sie eine pyramidenartige Architektur nutzen, um Merkmale auf mehreren Ebenen zu kombinieren.

Architektur von Feature Pyramid Networks

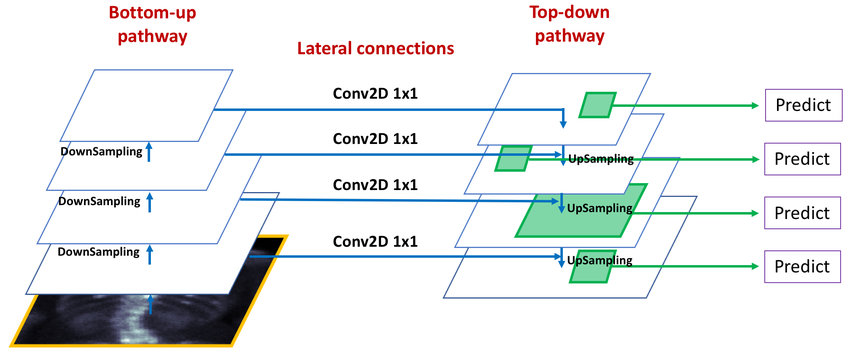

Ein FPN besteht aus zwei Hauptpfaden:

- Bottom-up-Pfad: Dies entspricht dem standardmäßigen Vorwärtsdurchlauf eines CNNs, bei dem Merkmale durch aufeinanderfolgende Faltungsschichten extrahiert werden.

- Top-down-Pfad mit lateralen Verbindungen: In diesem Pfad werden hochauflösende, semantisch reichhaltige Merkmale durch Up-Sampling schrittweise mit den entsprechenden niedrigeren Ebenen kombiniert. Laterale Verbindungen ermöglichen dabei die Fusion von Merkmalen aus dem Bottom-up-Pfad mit denen aus dem Top-down-Pfad.

Diese Struktur erlaubt es dem Netzwerk, Merkmale auf verschiedenen Skalenebenen zu nutzen und somit Objekte unterschiedlicher Größen effektiver zu erkennen.

Im klassischen CNN gibt es nur den Bottom-Up-Pfad:

- Tiefere Schichten (niedrig aufgelöst, „weiter unten“ im Netzwerk) erkennen sehr abstrakte, semantische Konzepte, z. B. „das könnte ein Kopf sein“ oder „hier ist eine Autotür“. Diese Schichten haben aber nur noch eine grobe Vorstellung von der räumlichen Auflösung – sie wissen also was, aber nicht mehr so genau wo.

- Höhere Schichten (frühere Layer, hoch aufgelöst) liefern sehr detaillierte Informationen, wie z. B. Kanten oder Texturen. Sie wissen also sehr genau wo etwas ist, aber noch nicht was es ist.

Das FPN verbindet nun beides: Es „füttert“ die abstrakte Information aus den tieferen Schichten zurück nach oben, indem es eine Top-Down-Pfadstruktur mit Skip-Verbindungen aufbaut. Dabei werden die groben semantischen Features der unteren Schichten auf die höhere Auflösung der oberen Schichten übertragen – die tiefe Schicht „vermutet“, was da sein könnte, und die hohen Schichten helfen, diese Vermutungen präzise zu lokalisieren.

Metaphorisch gesprochen:

Ein FPN denkt sich: „Ich glaube da unten ist ein Hund, aber ich seh ihn nur ganz unscharf. Lass mich kurz in den oberen Layern nachschauen, ob da vielleicht eine Schnauze, Ohren oder Pfoten auftauchen – dann bin ich mir sicher.“

Vorteile gegenüber herkömmlichen Convolutional Layern und CBAM

- Multi-Skalen-Erkennung: FPNs ermöglichen die effektive Erkennung von Objekten unterschiedlicher Größen, indem sie Merkmale auf mehreren Ebenen kombinieren.

- Effiziente Nutzung von Merkmalsinformationen: Durch die Kombination von Bottom-up- und Top-down-Pfaden können FPNs reichhaltigere Merkmalsrepräsentationen erzeugen.

- Verbesserte Leistung bei Objekterkennungsaufgaben: Studien haben gezeigt, dass FPNs die Genauigkeit von Objekterkennungsmodellen signifikant verbessern können.

Im Vergleich zu CBAM (Convolutional Block Attention Module), das die Aufmerksamkeit auf bestimmte Merkmale oder Bereiche innerhalb einer einzelnen Merkmalsebene lenkt, erweitern FPNs die Architektur, indem sie Informationen über mehrere Skalenebenen hinweg integrieren. Dies ermöglicht eine umfassendere und robustere Merkmalsrepräsentation, insbesondere für die Erkennung von Objekten unterschiedlicher Größen.

Vergleich zu klassischen CNNs und CBAM

| Architektur | Fokus | Limitierungen / Vorteile |

|---|---|---|

| Klassisches CNN | Starke, aber einseitige Feature-Hierarchie | Kleine Objekte gehen oft verloren |

| CBAM | Aufmerksamkeit für was und wo | Verbessert Fokus, aber keine Auflösungshierarchie |

| FPN | Kombination aus was, wo und wie groß | Starke Mehrskalenanalyse, ideal für Detektion aller Objektgrößen |

Implementierung eines FPNs mit TensorFlow/Keras

Die Integration eines FPNs in ein Keras-Modell kann wie folgt erfolgen:

import tensorflow as tf

from tensorflow.keras import layers, models

def build_fpn(backbone, num_pyramid_levels=3):

# Extrahiere Merkmalskarten aus dem Backbone

c3_output, c4_output, c5_output = backbone.outputs

# Top-Down-Pfad

p5 = layers.Conv2D(256, (1, 1), padding='same', name='fpn_c5p5')(c5_output)

p4 = layers.Add(name='fpn_p4add')([

layers.UpSampling2D(size=(2, 2), name='fpn_p5upsampled')(p5),

layers.Conv2D(256, (1, 1), padding='same', name='fpn_c4p4')(c4_output)

])

p3 = layers.Add(name='fpn_p3add')([

layers.UpSampling2D(size=(2, 2), name='fpn_p4upsampled')(p4),

layers.Conv2D(256, (1, 1), padding='same', name='fpn_c3p3')(c3_output)

])

# Zusätzliche Faltung zur Glättung

p3 = layers.Conv2D(256, (3, 3), padding='same', name='fpn_p3')(p3)

p4 = layers.Conv2D(256, (3, 3), padding='same', name='fpn_p4')(p4)

p5 = layers.Conv2D(256, (3, 3), padding='same', name='fpn_p5')(p5)

return [p3, p4, p5]

# Beispielhafte Verwendung mit einem ResNet50-Backbone

input_layer = layers.Input(shape=(224, 224, 3))

backbone = tf.keras.applications.ResNet50(include_top=False, input_tensor=input_layer)

fpn_outputs = build_fpn(backbone)

model = models.Model(inputs=input_layer, outputs=fpn_outputs)

model.summary()

In diesem Beispiel wird ein FPN auf Basis eines ResNet50-Backbones erstellt. Die Merkmalskarten der Stufen C3, C4 und C5 werden extrahiert und durch den Top-down-Pfad mit lateralen Verbindungen zu den P3, P4 und P5 Merkmalskarten kombiniert. Diese können dann für verschiedene Objekterkennungsaufgaben genutzt werden.

Feature Pyramid Networks bieten eine effektive Methode zur Verbesserung der Objekterkennung, insbesondere bei Objekten unterschiedlicher Größen. Durch die Kombination von Merkmalen auf mehreren Skalenebenen ermöglichen sie eine reichhaltigere und robustere Merkmalsrepräsentation. Im Vergleich zu herkömmlichen Convolutional Layern und Modulen wie CBAM bieten FPNs eine umfassendere Lösung für die Herausforderungen der Multi-Skalen-Objekterkennung.rk