In der Welt der Convolutional Neural Networks (CNNs) gibt es ständig neue Entwicklungen, die darauf abzielen, die Leistung und Effizienz dieser Modelle zu verbessern. Eine besonders bemerkenswerte Innovation ist das Convolutional Block Attention Module (CBAM). Dieses Modul erweitert herkömmliche Faltungsschichten um Mechanismen, die es dem Netzwerk ermöglichen, sich auf die wichtigsten Merkmale eines Eingabebildes zu konzentrieren.

Was ist CBAM?

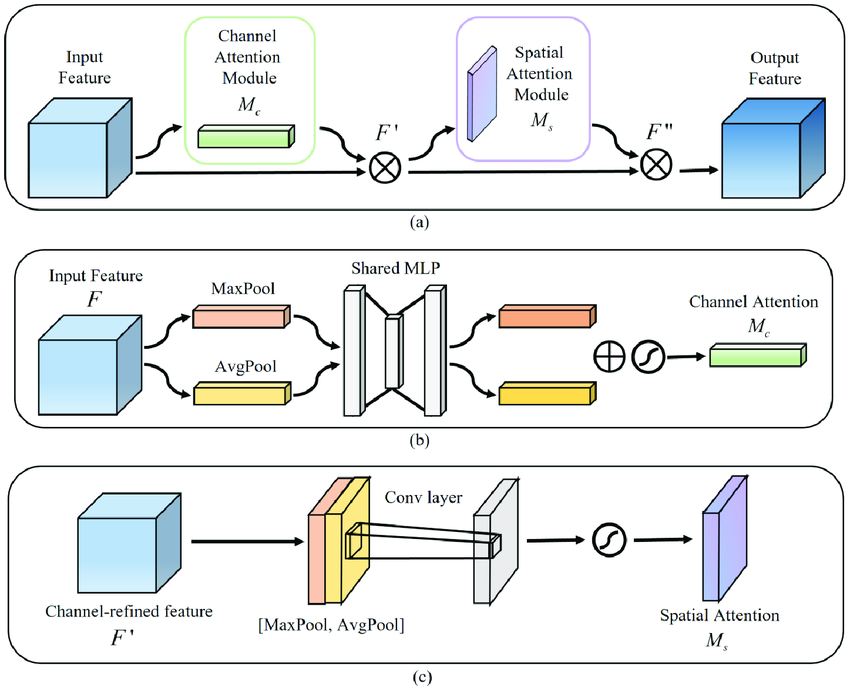

CBAM ist ein leichtgewichtiges und einfach zu implementierendes Modul, das die Repräsentationsfähigkeit von CNNs verbessert, indem es zwei Arten von Aufmerksamkeit kombiniert: Channel Attention und Spatial Attention. Durch diese Kombination kann das Netzwerk sowohl lernen, was (welche Merkmale) als auch wo (an welchen Positionen) es beachten soll. Das Ergebnis ist eine adaptive Verfeinerung der Feature Maps, die die Leistung des Netzwerks in verschiedenen Computer-Vision-Aufgaben steigert.

Aufbau von CBAM

CBAM besteht aus zwei aufeinanderfolgenden Komponenten:

- Channel Attention Module (CAM): Dieses Modul fokussiert sich darauf, die bedeutendsten Merkmale über alle Kanäle hinweg zu identifizieren. Es nutzt sowohl durchschnittliche als auch maximale Pooling-Operationen, um globale Informationen zu extrahieren, und führt diese durch ein gemeinsames neuronales Netzwerk, um eine Gewichtung für jeden Kanal zu ermitteln.

- Spatial Attention Module (SAM): Nachdem die Channel Attention angewendet wurde, bestimmt das Spatial Attention Module, welche Bereiche innerhalb der Feature Maps am wichtigsten sind. Es aggregiert Informationen über die Kanäle hinweg mittels durchschnittlicher und maximaler Pooling-Operationen und verwendet eine Faltungsschicht, um eine Gewichtung für jede räumliche Position zu berechnen.

Vorteile gegenüber herkömmlichen Convolutional Layern

Während traditionelle Faltungsschichten gleichmäßig auf alle Merkmale und Positionen eines Eingabebildes reagieren, ermöglicht CBAM eine gezielte Betonung relevanter Merkmale und Bereiche. Dies führt zu:

- Effizienterer Merkmalsextraktion: Durch die Hervorhebung wichtiger Kanäle und räumlicher Bereiche kann das Netzwerk relevantere Informationen aus den Eingabedaten extrahieren.

- Verbesserter Genauigkeit: Die adaptive Fokussierung auf bedeutende Merkmale und Positionen führt zu einer höheren Leistungsfähigkeit in Aufgaben wie Bildklassifikation und Objekterkennung.

- Geringer zusätzlicher Rechenaufwand: CBAM ist leichtgewichtig und fügt dem Netzwerk nur einen minimalen Overhead hinzu, was es zu einer praktischen Ergänzung für bestehende CNN-Architekturen macht.

Implementierung von CBAM mit TensorFlow/Keras

Die Integration von CBAM in ein Keras-Modell kann wie folgt erfolgen:

import tensorflow as tf

from tensorflow.keras import layers, models

def cbam_block(input_feature, ratio=8):

# Channel Attention Module

channel = input_feature.shape[-1]

shared_layer_one = layers.Dense(channel // ratio,

activation='relu',

kernel_initializer='he_normal',

use_bias=True,

bias_initializer='zeros')

shared_layer_two = layers.Dense(channel,

kernel_initializer='he_normal',

use_bias=True,

bias_initializer='zeros')

avg_pool = layers.GlobalAveragePooling2D()(input_feature)

avg_pool = shared_layer_one(avg_pool)

avg_pool = shared_layer_two(avg_pool)

max_pool = layers.GlobalMaxPooling2D()(input_feature)

max_pool = shared_layer_one(max_pool)

max_pool = shared_layer_two(max_pool)

channel_attention = layers.Add()([avg_pool, max_pool])

channel_attention = layers.Activation('sigmoid')(channel_attention)

channel_attention = layers.Reshape((1, 1, channel))(channel_attention)

x = layers.Multiply()([input_feature, channel_attention])

# Spatial Attention Module

avg_pool = layers.Lambda(lambda x: tf.reduce_mean(x, axis=-1, keepdims=True))(x)

max_pool = layers.Lambda(lambda x: tf.reduce_max(x, axis=-1, keepdims=True))(x)

concat = layers.Concatenate(axis=-1)([avg_pool, max_pool])

spatial_attention = layers.Conv2D(filters=1,

kernel_size=7,

strides=1,

padding='same',

activation='sigmoid',

kernel_initializer='he_normal',

use_bias=False)(concat)

x = layers.Multiply()([x, spatial_attention])

return x

# Beispiel für die Verwendung des CBAM-Blocks in einem Modell

input_layer = layers.Input(shape=(128, 128, 3))

x = layers.Conv2D(32, (3, 3), activation='relu', padding='same')(input_layer)

x = cbam_block(x)

x = layers.Conv2D(64, (3, 3), activation='relu', padding='same')(x)

x = layers.Flatten()(x)

output_layer = layers.Dense(10, activation='softmax')(x)

model = models.Model(inputs=input_layer, outputs=output_layer)

model.summary()

In diesem Beispiel wird ein CBAM-Block nach einer Faltungsschicht eingefügt, um die Merkmalsrepräsentation zu verfeinern. Diese Struktur kann je nach Anwendungsfall und gewünschter Netzwerkarchitektur angepasst werden.

Das Convolutional Block Attention Module stellt eine effektive Erweiterung für Convolutional Neural Networks dar, indem es die Aufmerksamkeit des Netzwerks auf die wichtigsten Merkmale und Bereiche eines Eingabebildes lenkt. Durch die Kombination von Channel und Spatial Attention ermöglicht CBAM eine verbesserte Merkmalsextraktion und führt zu einer höheren Genauigkeit bei verschiedenen Computer-Vision-Aufgaben. Dank seines leichtgewichtigen Designs kann es problemlos in bestehende CNN-Architekturen integriert werden, ohne signifikanten zusätzlichen Rechenaufwand