Einführung in künstliche neuronale Netze

Künstliche neuronale Netze (NN oder KNN) sind heute das Rückgrat vieler moderner Technologien, von Sprachassistenten wie Siri und Alexa bis hin zu selbstfahrenden Autos und medizinischer Bildverarbeitung. Ihre Struktur und Funktionsweise sind von den biologischen neuronalen Netzen im menschlichen Gehirn inspiriert. In diesem Tutorial werden wir die Grundkonzepte künstlicher neuronaler Netze erklären, indem wir zuerst auf das biologische Vorbild eingehen und dann eine der einfachsten und wichtigsten Netzwerkkonfigurationen, das Feedforward-Netzwerk (FF-Netz), vorstellen.

1. Biologische Neuronen: Das Vorbild für künstliche neuronale Netze

Um die Funktionsweise von künstlichen neuronalen Netzen zu verstehen, sollten wir zuerst einen Blick auf das biologische Neuron werfen, das die Inspiration für diese Technologie ist. Unser Gehirn besteht aus Milliarden von Neuronen, die auf beeindruckende Weise zusammenarbeiten, um alle unsere Gedanken, Gefühle und Handlungen zu steuern.

Wie funktioniert ein biologisches Neuron?

Ein Neuron kann man sich wie eine spezialisierte Kommunikationszelle vorstellen. Es empfängt Signale von anderen Neuronen, verarbeitet diese und gibt dann, wenn nötig, ein Signal weiter. Jedes Neuron besteht aus drei wesentlichen Teilen:

- Dendriten: Diese baumartigen Verzweigungen empfangen Signale von benachbarten Neuronen. Man kann sich die Dendriten als Antennen vorstellen, die Informationen sammeln.

- Zellkörper (Soma): Der Zellkörper ist das Kontrollzentrum des Neurons. Hier werden die empfangenen Signale summiert und verarbeitet. Wenn diese Signale eine bestimmte Schwelle überschreiten, entscheidet der Zellkörper, das Signal weiterzuleiten.

- Axon: Das Axon ist wie ein langes Kabel, das das Signal an das nächste Neuron weiterleitet. Am Ende des Axons befinden sich die sogenannten Synapsen, die als Schaltstellen fungieren, um das Signal zu übertragen.

Ein biologisches Neuron „feuert“ nur dann ein Signal weiter, wenn die empfangenen Signale zusammen eine bestimmte Schwelle überschreiten – ein Prinzip, das auch in künstlichen neuronalen Netzen verwendet wird.

Warum neuronale Netze als Modell?

Das faszinierende an unserem Gehirn ist seine Fähigkeit, komplexe Aufgaben wie Mustererkennung, Entscheidungsfindung und Lernen zu bewältigen. Diese unglaubliche Flexibilität und Lernfähigkeit entsteht durch die Verbindungen und Interaktionen zwischen den Neuronen. Forscher haben erkannt, dass es möglich sein könnte, dieses Prinzip zu nutzen, um Maschinen beizubringen, ähnliche Aufgaben zu lösen. Das Ergebnis ist das künstliche neuronale Netz, das – vereinfacht gesagt – eine digitale Version unseres biologischen Gehirns darstellt.

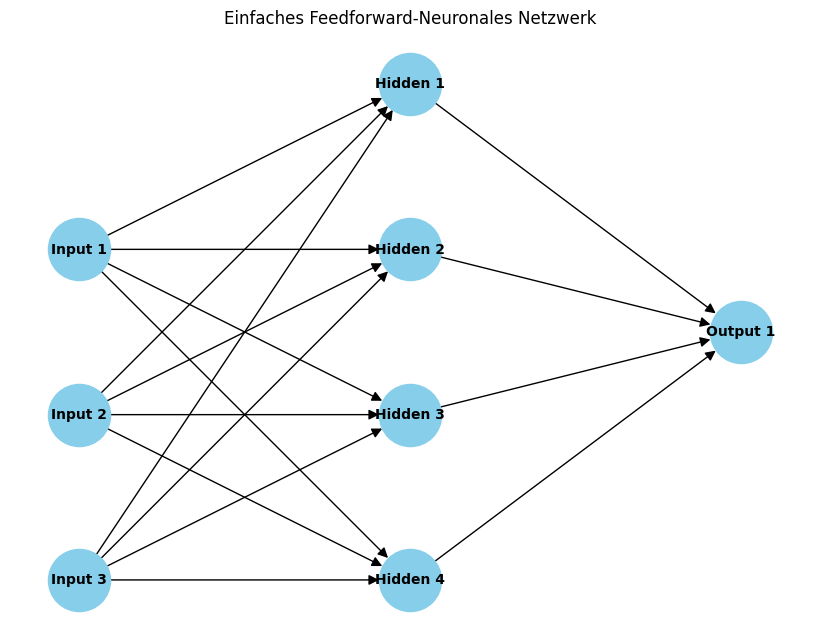

2. Feedforward-Neuronale Netze (FF-Netze)

Nun, da wir das biologische Neuron und dessen Funktionsweise verstanden haben, wenden wir uns der künstlichen Version zu. Feedforward-Netzwerke (FF-Netze) sind die einfachste Form von künstlichen neuronalen Netzen. In einem FF-Netzwerk fließen die Informationen immer nur in eine Richtung – von der Eingabeschicht über die verborgenen Schichten zur Ausgabeschicht. Es gibt also keine Rückkopplungen oder Schleifen, wie es in anderen komplexeren Netzwerken der Fall sein kann.

Aufbau eines Feedforward-Netzwerks

Ein FF-Netz besteht aus mehreren Schichten, die in einem geordneten Ablauf miteinander verbunden sind. Diese Schichten sind:

- Eingabeschicht: In der Eingabeschicht werden die Rohdaten des Problems eingespeist. Stellen Sie sich vor, Sie möchten ein FF-Netzwerk trainieren, um handgeschriebene Ziffern zu erkennen. In diesem Fall könnte die Eingabeschicht aus einer Reihe von Neuronen bestehen, die die Pixel eines Bildes darstellen. Jedes Neuron in dieser Schicht ist für ein bestimmtes Merkmal oder eine Dimension der Eingabedaten verantwortlich.

- Verborgene Schichten: Dies sind die Schichten, in denen die eigentliche Verarbeitung stattfindet. Jedes Neuron in einer verborgenen Schicht empfängt Signale von den Neuronen der vorherigen Schicht, verarbeitet diese und leitet das Ergebnis an die nächste Schicht weiter. Diese Schichten heißen „verborgen“, weil sie für den Anwender nicht direkt sichtbar sind – sie arbeiten im Hintergrund. Je mehr verborgene Schichten ein Netzwerk hat, desto komplexer kann es werden. In der Praxis wird das oft als Deep Learning bezeichnet, wenn sehr viele dieser verborgenen Schichten vorhanden sind.

- Ausgabeschicht: Die letzte Schicht des Netzwerks liefert das Endergebnis. Bei der Ziffernerkennung könnte die Ausgabeschicht beispielsweise zehn Neuronen umfassen, von denen jedes eine Ziffer von 0 bis 9 repräsentiert. Das Neuron, das am höchsten aktiviert ist, bestimmt, welche Ziffer das Netzwerk als Vorhersage ausgibt.

Funktionsweise eines künstlichen Neurons

Wie genau verarbeitet ein künstliches Neuron Informationen? Die Grundidee ist einfach und elegant:

- Eingabe: Jedes Neuron empfängt mehrere Signale von den Neuronen der vorherigen Schicht. Diese Signale können als Zahlenwerte betrachtet werden (z. B. Intensitäten von Pixeln in einem Bild).

- Gewichte: Jedes dieser Signale wird mit einem bestimmten Gewicht multipliziert. Diese Gewichte bestimmen, wie stark ein bestimmtes Signal die Ausgabe des Neurons beeinflusst. Ähnlich wie bei biologischen Synapsen, wo einige Verbindungen stärker und andere schwächer sind, steuern diese Gewichte die „Wichtigkeit“ der Signale.

- Summation: Das Neuron summiert die gewichteten Eingaben, um einen Gesamtwert zu berechnen. Diese Summierung bestimmt, wie stark das Neuron aktiviert wird.

- Aktivierungsfunktion: Schließlich wird dieser summierte Wert durch eine Aktivierungsfunktion geleitet. Diese Funktion entscheidet, ob und wie stark das Neuron „feuert“. Eine der häufigsten Aktivierungsfunktionen ist die sigmoidale Funktion, die den Ausgangswert auf einen Bereich zwischen 0 und 1 beschränkt, oder die ReLU-Funktion (Rectified Linear Unit), die nur positive Werte durchlässt.

Beispiel: Verarbeitung eines Bildes

Stellen Sie sich vor, wir möchten ein Feedforward-Netzwerk trainieren, um handgeschriebene Zahlen zu erkennen. Ein Bild mit einer Zahl, wie die „5“, wird in die Eingabeschicht eingespeist, wobei jedes Neuron einen Pixel des Bildes darstellt. Diese Informationen werden dann durch die versteckten Schichten weitergeleitet, wo das Netzwerk versucht, Muster zu erkennen (z. B. die Form von Schleifen und Linien). Am Ende der Verarbeitung entscheidet die Ausgabeschicht, welche Zahl am wahrscheinlichsten ist – in diesem Fall „5“.

Feedforward-Netzwerke bilden die Grundlage vieler erfolgreicher Anwendungen in der künstlichen Intelligenz. Sie sind zwar in ihrem Aufbau einfach, können aber durch eine geschickte Wahl der Anzahl der Neuronen, Schichten und Aktivierungsfunktionen sehr leistungsstark werden. Im nächsten Abschnitt Spielerisch NNs erkunden werden wir uns „live“ ansehen, wie diese Netzwerke arbeiten.